در عصر دیجیتال امروز، دادهها به عنوان طلای جدید سازمانها شناخته میشوند، اما مدیریت دانش سازمانی بیش از پیش چالشبرانگیز شده است. سازمانهای بزرگ اغلب با انبوهی از دادههای ساختاریافته، مانند رکوردهای ذخیرهشده در پایگاههای داده SQL Server، و غیرساختاریافته، از جمله آییننامهها، دستورالعملهای فنی، نقشهها و مستندات در فرمتهای PDF یا Office، دست و پنجه نرم میکنند. مشکل اصلی نه تنها حجم این دادههاست، بلکه پراکندگی آنها در “جزایر اطلاعاتی” است که بازیابی سریع و دقیق اطلاعات را دشوار میسازد.

گروه تحول دیجیتال میراکام با بهرهگیری از فناوریهای نوین، راهحلی برای این چالش ارائه میدهد. RAG نه تنها دقت پاسخها را افزایش میدهد، بلکه با تمرکز بر فهم semantics محتوا، به ویژه در زبانهای پیچیدهای مانند فارسی، امکان ارائه پاسخهای مستند و قابل اعتماد را فراهم میکند.

این فناوری، که بر پایه مدلهای زبانی بزرگ (LLMs) مانند Llama 3 یا Mixtral بنا شده، از “توهم” (hallucination) مدلها جلوگیری کرده و سازمانها را قادر میسازد تا دانش پراکنده خود را به یک سیستم تعاملی هوشمند تبدیل کنند. طبق مطالعات اخیر، سیستمهای مبتنی بر RAG میتوانند دقت پاسخدهی را تا ۳۰-۵۰٪ افزایش دهند، به ویژه در حوزههای تخصصی که اصطلاحات فنی غالب هستند.

RAG: کلید تحول مدیریت دانش سازمانی

در دنیای مدرن کسبوکار، سازمانها با چالش بزرگی روبرو هستند: انبوهی از دادههای تخصصی و حیاتی که در هزارتوی فایلهای PDF، آییننامهها، نقشههای فنی، گزارشهای اکسل، و پایگاههای داده ساختاریافته پراکنده شدهاند. این «جزایر اطلاعاتی» مانع از دسترسی سریع، مستند و قابل اعتماد کارکنان به دانش مورد نیاز میشوند. سیستمهای مدیریت دانش سنتی (KMS) تنها به عنوان مخزنی برای ذخیرهسازی عمل میکنند، اما توانایی فهم عمیق محتوا و ارائه پاسخهای دقیق و خلاصهشده را ندارند.

اینجاست که رویکرد Retrieval-Augmented Generation (RAG) وارد میشود. RAG نه تنها یک موتور جستجوی پیشرفته، بلکه یک معماری هوش مصنوعی است که قدرت مدلهای زبان بزرگ (LLM) را با دانش داخلی و اختصاصی سازمان ترکیب میکند تا پدیدهای به نام «دستیار هوشمند سازمانی» را خلق کند. هدف، تبدیل مدیریت دانش سازمانی از یک چالش به یک مزیت رقابتی است.

در این مقاله جامع از مجله میراکام، به بررسی عمیق جنبههای فنی، چالشها، بهترین شیوهها و راهکارهای پیادهسازی RAG میپردازیم. اگر سازمان شما هم با پراکندگی دانش دست و پنجه نرم میکند، این راهنما میتواند الهامبخش پروژههای هوش مصنوعی شما باشد.

درک معماری RAG: پایهای برای دستیاران هوشمند سازمانی

معماری RAG یک رویکرد ترکیبی است که جستجوی اطلاعات (Retrieval) را با تولید متن (Generation) ادغام میکند. در هسته آن، RAG دادههای خارجی را در زمان واقعی بازیابی کرده و به عنوان زمینه (context) به مدل زبانی ارائه میدهد، تا پاسخها بر اساس واقعیتهای سازمانی تولید شوند نه حدس و گمان. این روش در مقابل مدلهای سنتی LLM که اغلب به دانش پیشآموزشدیده محدود هستند، برتری دارد زیرا امکان بهروزرسانی پویا دانش را بدون نیاز به آموزش مجدد مدل فراهم میکند.

برای مثال، در یک سازمان صنعتی، کارمندی که به دنبال دستورالعمل فنی خاصی است، میتواند سؤال خود را مطرح کند و RAG با جستجو در مستندات داخلی، پاسخی دقیق با ارجاع به منبع ارائه دهد. این معماری شامل سه مرحله اصلی است: ingestion دادهها، retrieval و generation.

یک دستیار هوشمند سازمانی مبتنی بر RAG، فراتر از یک چتبات ساده عمل میکند؛ این سیستم یک پایپلاین مهندسیشده داده و بازیابی است که تضمین میکند پاسخها نه حدس و گمان، بلکه مستند به واقعیتهای سازمانی هستند.

مدیریت دادهها و منابع: پایه موفقیت در RAG

یکی از کلیدیترین مراحل در پیادهسازی RAG، مدیریت دادهها (Data Ingestion) است. این مرحله، بنیان کیفیت پاسخهاست. اگر دادهها به درستی آمادهسازی نشوند، هیچ مدل پیشرفتهای نمیتواند خطاها را جبران کند. سیستم باید قابلیت اتصال به منابع ساختاریافته مانند SQL Server – با قابلیت اجرای کوئریهای پیچیده و ترکیبی – و پردازش منابع غیرساختاریافته مانند فایلهای PDF، Word، Excel و PowerPoint را داشته باشد.

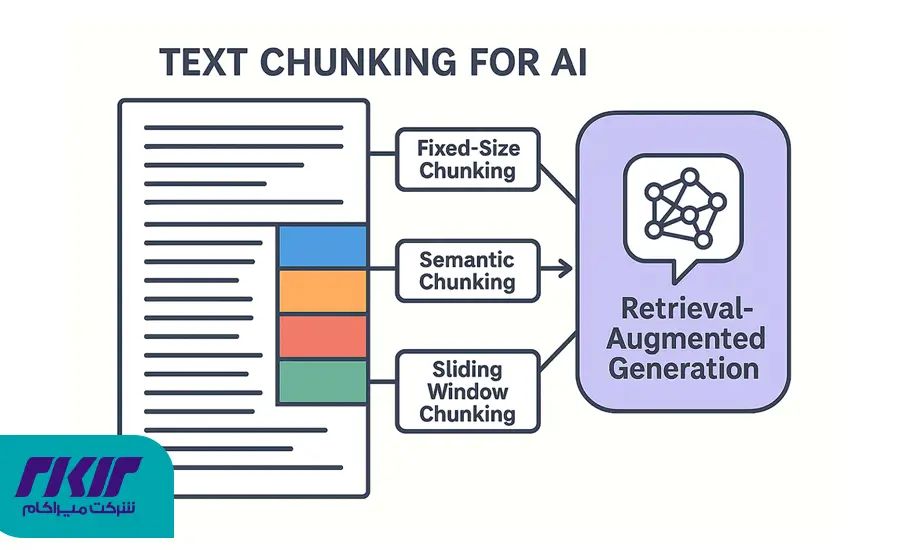

رویکرد سنتی برش ثابت (fixed-size chunking) – که متن را به قطعات با اندازه ثابت تقسیم میکند – اغلب ناکارآمد است زیرا ساختار منطقی سند را نادیده میگیرد. در عوض، استراتژی قطعهبندی هوشمند (smart chunking) ضروری است. این روش با استفاده از الگوریتمهای پیشرفته، عناصری مانند سرصفحهها، پانویسها، جداول و نمودارها را تشخیص داده و ساختار سند را حفظ میکند.

برای مثال، در یک سند PDF فنی، smart chunking میتواند جدول مشخصات فنی را به عنوان یک واحد مستقل استخراج کند، نه اینکه آن را در میان قطعات متنی تقسیم نماید. Chunking بازگشتی (Recursive Chunking) نیز مفید است: سند ابتدا به قطعات بزرگ و سپس در صورت لزوم به قطعات کوچکتر تقسیم میشود تا دقت بازیابی در سناریوهای مختلف حفظ شود.

ابزارهایی مانند Microsoft Azure Document Intelligence (DI) یا Unstructured.io در این زمینه برجسته هستند. Azure DI با بهرهگیری از مدلهای یادگیری ماشین، قادر به استخراج خودکار عناصر ساختاری است، در حالی که Unstructured.io بر پردازش اسناد پیچیده تمرکز دارد. پیادهسازی این استراتژی نه تنها دقت retrieval را افزایش میدهد، بلکه زمان پردازش را کاهش میدهد. در عمل، برای زبان فارسی که با مسائل مانند جهت متن (RTL) و اصطلاحات خاص روبرو است، انتخاب ابزارهایی با پشتیبانی محلی ضروری است تا از خطاهای پردازش جلوگیری شود.

موتور جستجو و بازیابی: قلب تپنده دقت در RAG

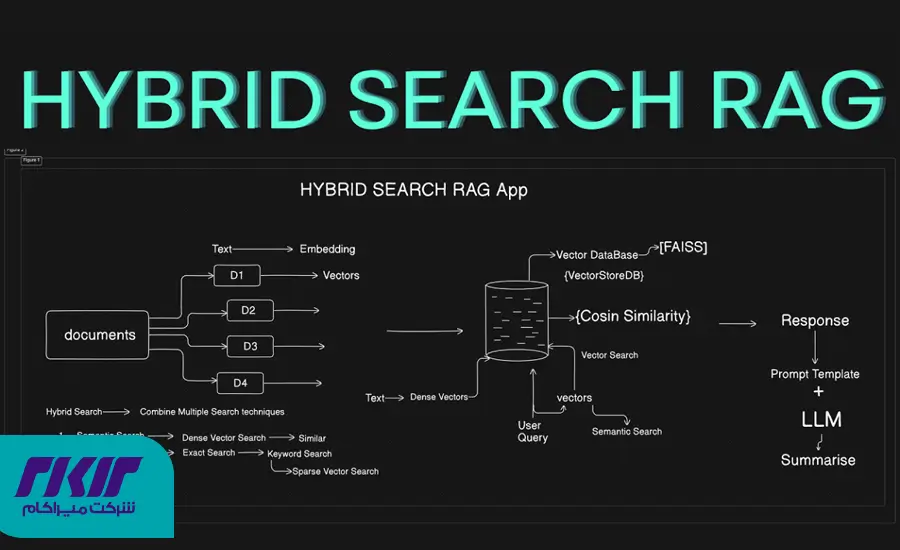

موتور جستجو (Retrieval Engine) جایی است که جادوی RAG رخ میدهد. این جزء، وظیفه یافتن مرتبطترین قطعات داده (Context) را از میان میلیونها سند سازمانی دارد. برای تضمین دقت بالا، استفاده از جستجوی ترکیبی (hybrid search) الزامی است.

این رویکرد، جستجوی معنایی (dense vector search)،که بر اساس شباهت مفهومی عمل میکند، را با جستجوی کلمات کلیدی (sparse search مانند BM25) ترکیب مینماید. در مواجهه با اصطلاحات فنی یا کدهای خاص، جایی که جستجوی معنایی ممکن است ناکارآمد باشد، BM25 دقت را حفظ میکند. نتایج این دو روش با تکنیکهایی مانند Reciprocal Rank Fusion (RRF) ترکیب میشوند تا یک مجموعه بهینه از اسناد برای ارسال به LLM تولید شود.

پایگاه دادههای وکتوری مانند Qdrant، Milvus، Weaviate یا Elasticsearch گزینههای ایدهآلی هستند. این دیتابیسها قابلیت ذخیره و جستجوی سریع وکتورهای embedding را فراهم میکنند. علاوه بر این، لایه رتبهبندی مجدد (re-ranking) با مدلهای cross-encoder ضروری است؛ این مدلها اسناد بازیابیشده را مجدداً ارزیابی کرده و بهترینها را برای generation انتخاب میکنند، که میتواند دقت را تا ۲۰٪ بهبود بخشد.

مدل زبانی و تولید پاسخ: از کنترل توهم تا تعامل صوتی

در مرحله generation، تمرکز بر جلوگیری از hallucination است. سیستم باید تنها بر اساس context فراهم شده پاسخ دهد و در صورت عدم وجود اطلاعات، صریحاً عدم آگاهی خود را اعلام کند. این امر با تکنیکهایی مانند prompt engineering پیشرفته و محدودیت context size محقق میشود.

علاوه بر این، ارجاعدهی (citations) به منبع دقیق اعتمادپذیری را افزایش میدهد. با ادغام Speech-to-Text (STT) و Text-to-Speech (TTS) برای زبان فارسی، سیستم میتواند مکالمات طبیعی را پشتیبانی کند، با latency کمتر از ۱ ثانیه برای پاسخدهی واقعی زمان.

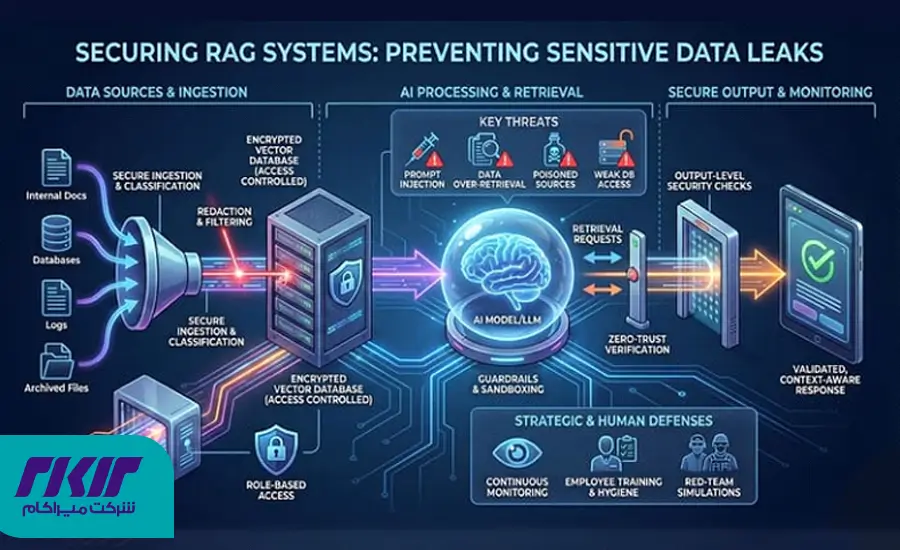

الزامات امنیتی و معماری: حفاظت از دانش سازمانی

امنیت در سیستمهای RAG حیاتی است. کنترل دسترسی مبتنی بر نقش (RBAC) با یکپارچگی Active Directory یا سیستمهای داخلی، دسترسی کاربران را محدود میکند. فیلترینگ metadata در سطح موتور جستجو مانع نشت اسناد محرمانه میشود. در حوزهAIsecurity، دفاع در برابر حملات prompt injection و jailbreaking ضروری است. prompt injection زمانی رخ میدهد که کاربر ورودی مخربی وارد کند تا مدل را فریب دهد؛ راهکارها شامل sandboxing prompts و استفاده از مدلهای دفاعی مانند guardrails هستند.

علاوه بر این، محرمانگی دادهها با جلوگیری از ارسال اطلاعات به مدلهای عمومی مانند OpenAI تضمین میشود. دو سناریو اصلی وجود دارد: on-premise با مدلهای open-source روی سرورهای داخلی، یا cloud-based با سرویسهای مدیریتشده و تمرکز بر privacy. مقایسه این دو نشان میدهد on-premise کنترل بیشتری ارائه میدهد اما هزینه اولیه بالاتری دارد، در حالی که cloud مقیاسپذیری آسانتری دارد.

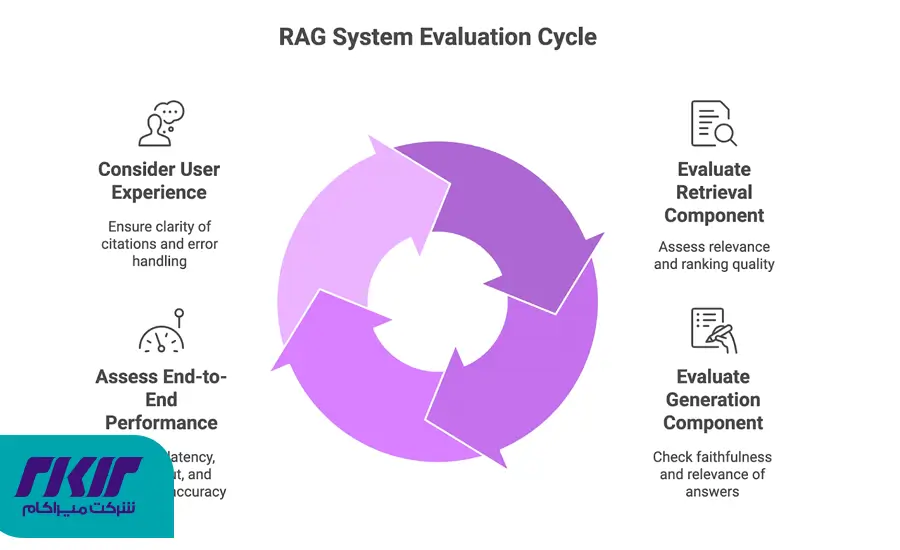

ارزیابی و تضمین کیفیت: اندازهگیری عملکرد RAG

برای ارزیابی سیستم، فریمورکهایی مانند RAGAS یا TruLens ایدهآل هستند. این ابزارها شاخصهایی مانند faithfulness (وفاداری پاسخ به منبع)، answer relevance (مرتبط بودن پاسخ با سؤال) و context precision (دقت متون بازیابیشده) را اندازهگیری میکنند. برای مثال، faithfulness با مقایسه پاسخ با context محاسبه میشود و باید بالای ۹۰٪ باشد.

این ارزیابیها به صورت خودکار روی دیتاستهای تست انجام شده و امکان بهبود مداوم را فراهم میکنند.

| شاخص ارزیابی | هدف اصلی | تعریف عملی |

|---|---|---|

| وفاداری (Faithfulness) | کنترل توهم | آیا پاسخ تولیدشده کاملاً بر اساس متون بازیابیشده (Context) است؟ |

| ارتباط پاسخ (Answer Relevance) | دقت پاسخ | آیا پاسخ نهایی واقعاً به پرسش کاربر پاسخ میدهد؟ |

| دقت متون (Context Precision) | کارایی بازیابی | آیا قطعاتی که موتور بازیابی کرده، مرتبطترین اطلاعات را شامل میشوند؟ |

نتیجهگیری: تحول دیجیتال سازمان شما با RAG

پیادهسازی دستیار هوشمند مبتنی بر RAG نه تنها مدیریت دانش را هوشمند میکند، بلکه بهرهوری را افزایش داده و تصمیمگیریها را آگاهانهتر میسازد. با توجه به چالشهای زبان فارسی و نیاز به امنیت بالا، انتخاب شریک فنی متخصص ضروری است.

در میراکام، با تجربه گسترده در پیاده سازی RAG فارسی، آمادهایم تا راهکارهای سفارشی ارائه دهیم. آیا سازمان شما آماده تحول دیجیتال است؟ برای مشاوره رایگان و شروع پروژه هوش مصنوعی، با [info@mirakam.com] تماس بگیرید یا فرم سایت mirakam.com را پر کنید. هوش مصنوعی را به خدمت کسبوکارتان درآورید!

سوالات متداول

۱. RAG چیست و چگونه به مدیریت دانش سازمانی کمک میکند؟

RAG (Retrieval-Augmented Generation) یک رویکرد مبتنی بر هوش مصنوعی است که از ترکیب جستجوی اطلاعات و تولید محتوا برای بهبود دقت پاسخها استفاده میکند. این فناوری به سازمانها کمک میکند تا دانش پراکنده خود را به یک سیستم تعاملی و هوشمند تبدیل کنند.

۲. چرا استفاده از RAG میتواند برای زبان فارسی چالشبرانگیز باشد؟

به دلیل پیچیدگیهای زبان فارسی مانند جهت متن (RTL) و اصطلاحات خاص، پردازش دادهها و استخراج اطلاعات از منابع غیرساختاریافته مانند PDF یا Word نیازمند ابزارهایی با پشتیبانی محلی است تا از خطاهای پردازش جلوگیری شود.

۳. چطور سیستمهای مبتنی بر RAG دقت پاسخدهی را افزایش میدهند؟

با استفاده از جستجوهای ترکیبی و ترکیب جستجوی معنایی و کلمات کلیدی، سیستمهای RAG میتوانند اطلاعات دقیقتر و مرتبطتر را بازیابی کنند، که منجر به افزایش دقت پاسخدهی تا ۳۰-۵۰٪ میشود.

۴. چگونه RAG از “توهم” (hallucination) مدلها جلوگیری میکند؟

RAG تنها بر اساس اطلاعات بازیابیشده از منابع معتبر و داخلی پاسخ میدهد و در صورت عدم وجود اطلاعات، صریحاً عدم آگاهی خود را اعلام میکند.

۵. چه ابزارهایی برای مدیریت دادهها و منابع در RAG استفاده میشود؟

ابزارهایی مانند Microsoft Azure Document Intelligence (DI) و Unstructured.io برای پردازش منابع غیرساختاریافته مانند PDF و Word و همچنین مدلهای پیشرفته chunking برای حفظ ساختار منطقی اسناد استفاده میشود.

۶. چگونه میتوان از RAG در سازمانهای صنعتی استفاده کرد؟

در سازمانهای صنعتی، RAG میتواند برای جستجو و بازیابی دستورالعملهای فنی، نقشهها، و سایر مستندات استفاده شود و پاسخهای دقیقی به سوالات فنی کارکنان ارائه دهد.

۷. چه مدلهای زبانی برای RAG مناسب هستند؟

مدلهای زبانی بزرگی مانند Llama 3 و Mixtral برای پیادهسازی RAG مناسب هستند زیرا توانایی پردازش اطلاعات پیچیده را دارند و به طور خاص برای زبانهای مختلف بهینهسازی شدهاند.

۸. چگونه میتوان امنیت دادهها را در سیستمهای RAG تضمین کرد؟

استفاده از کنترل دسترسی مبتنی بر نقش (RBAC) و فیلترینگ metadata در سطح موتور جستجو، از دسترسی غیرمجاز به دادههای حساس جلوگیری میکند. همچنین، دفاع در برابر حملات prompt injection و حفاظت از اطلاعات با استفاده از مدلهای دفاعی ضروری است.

۹. چگونه میتوان عملکرد سیستمهای RAG را ارزیابی کرد؟

ابزارهای ارزیابی مانند RAGAS و TruLens میتوانند شاخصهای وفاداری (faithfulness)، ارتباط پاسخ (answer relevance)، و دقت متون بازیابیشده (context precision) را اندازهگیری کنند.

۱۰. چگونه میتوان یک دستیار هوشمند سازمانی مبتنی بر RAG را پیادهسازی کرد؟

پیادهسازی RAG نیاز به منابع دادهای مناسب، انتخاب موتور جستجو و مدلهای زبانی مناسب، و استفاده از استراتژیهای امنیتی برای حفاظت از دادههای سازمانی دارد. همکاری با شرکای فنی متخصص، مانند گروه تحول دیجیتال میراکام، میتواند در این فرآیند کمک کند.

۱۱. پایگاه داده وکتوری (Vector Database) چیست و چگونه در سیستمهای RAG استفاده میشود؟

پایگاه داده وکتوری برای ذخیره و جستجوی وکتورهای عددی (embedding) استفاده میشود که نمایانگر ویژگیهای دادهها هستند. در سیستمهای RAG، این پایگاهها به جستجوی سریع و دقیق دادههای مرتبط کمک میکنند، به ویژه برای جستجوی معنایی بر اساس مفاهیم. پایگاههای وکتوری مانند Qdrant و Milvus برای این منظور کاربرد دارند.

۱۲. امنیتAIچیست و چگونه در سیستمهای RAG اعمال میشود؟

امنیتAIبه مجموعه تدابیر و روشهایی اطلاق میشود که برای حفاظت از دادهها، مدلها و فرآیندهای هوش مصنوعی در برابر تهدیدات و حملات طراحی شده است. در سیستمهای RAG، امنیتAIشامل کنترل دسترسی مبتنی بر نقش (RBAC)، جلوگیری از حملات prompt injection و تضمین حفاظت از دادهها است. این اقدامات مانع از دسترسی غیرمجاز به دادههای حساس و از فریب مدلها جلوگیری میکنند.